Bildbasierte Gewalt, Pornoplattformen und der Digital Services Act

Im Dezember 2021 befasste sich der IMCO-Ausschuss (Ausschuss für Binnenmarkt und Verbraucherschutz) des Europäischen Parlaments mit einem Bericht zum Digital Services Act (DSA), der die Gesetzeslage zu digitalen Diensten in der EU neu regeln soll. Neben anderen Ergänzungen schlug der Ausschuss vor, Anforderungen für nutzergenerierte pornografische Inhalte einzuführen. Damit soll die bildbasierte Gewalt auf Pornoplattformen bekämpft werden – ein wachsendes Problem in ganz Europa. HateAid hat sich an Expert*innen auf dem Gebiet des Internetrechts und des bildbasierten sexuellen Missbrauchs gewandt, um die Vorschläge des Ausschusses einzuordnen.

Auf unsere Anfrage haben Professor Clare McGlynn von der Durham University und Professor Lorna Woods von der University of Essex das Gutachten „Image-Based Sexual Abuse, Porn Platforms and the Digital Services Act“ verfasst.

Die 4 zentralen Erkenntnisse des Gutachtens sind:

- Nicht einvernehmlich publizierte Inhalte auf Pornoplattformen sind leicht zugänglich, oft sogar auf den Titelseiten der beliebtesten Pornoplattformen.

- Betroffene von bildbasierter sexueller Gewalt berichten von lebensverändernden und lebensbedrohenden Schäden.

- Um den Betroffenen zu helfen, sind Regulierungen für Pornoplattformen erforderlich.

- Der DSA kann Mindeststandards zum Schutz vor sexuellem Missbrauch durch Bilder garantieren.

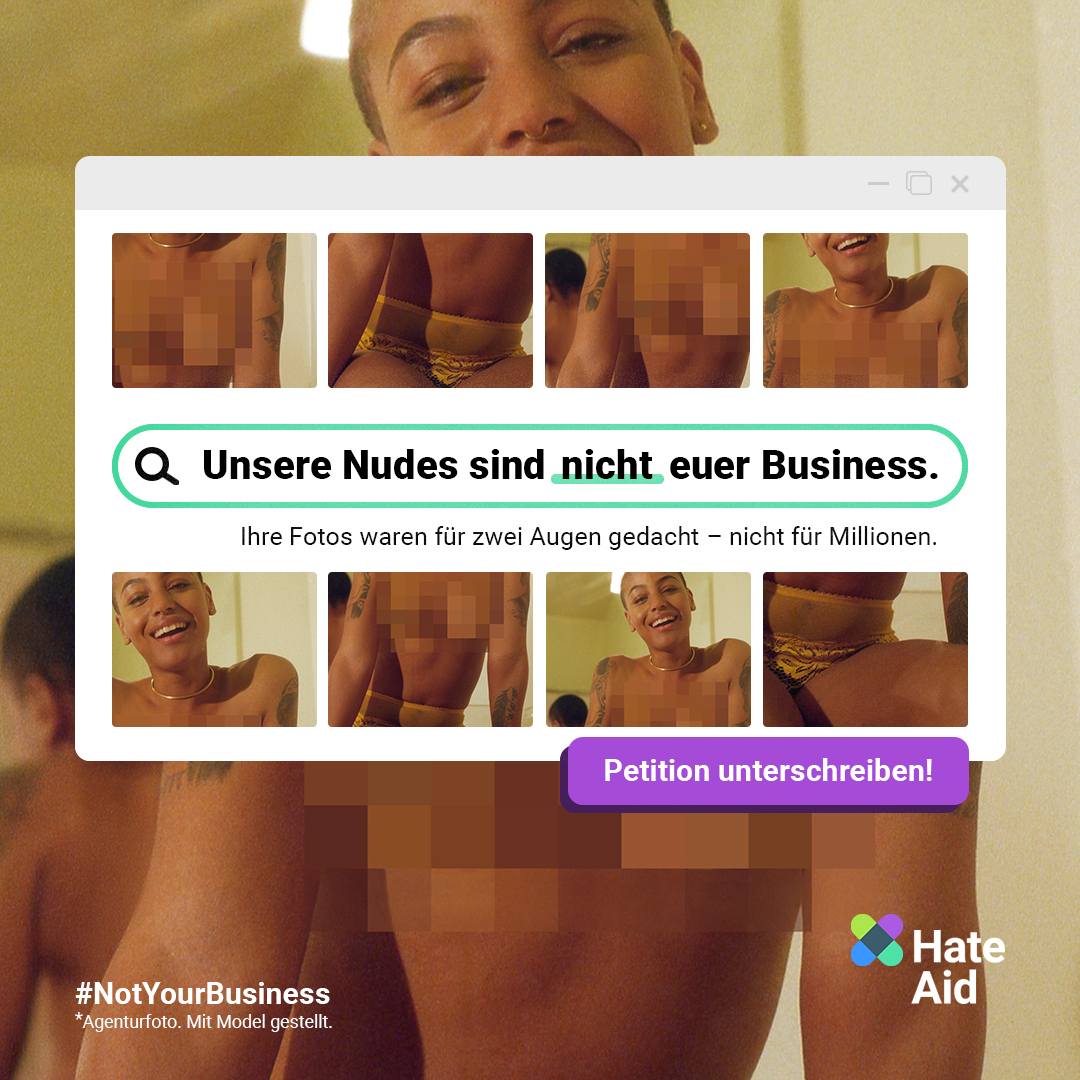

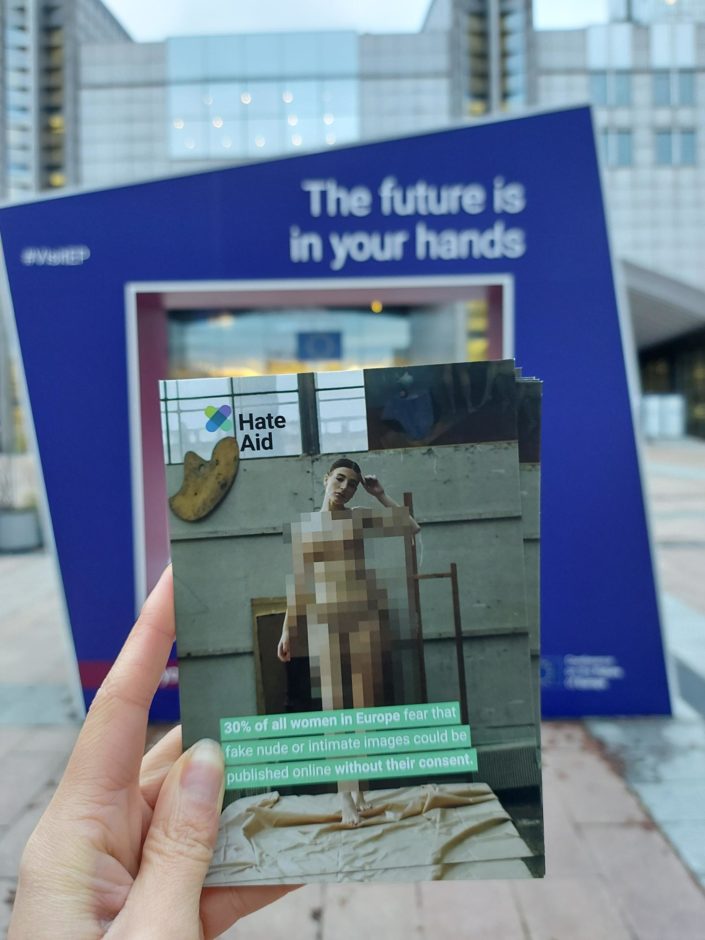

Angst vor intimen Bildern, die online publiziert werden

Professor McGlynn und Professor Woods weisen in ihrem Gutachten darauf hin, dass die erhobenen Daten zwar nur spärlich sind, aber die Einblicke, die verfügbar sind, lassen verheerende Zustände erahnen. Im Jahr 2020 wurden über 100.000 Bilder von irischen Frauen und Mädchen im Internet veröffentlicht. In Italien wurden ähnliche Websites aufgedeckt, auf denen Tausende von Nutzer*innen geklaute und gefälschte Nacktbilder verbreiten. Noch schlimmer: Viele Frauen wissen nicht einmal, dass Nacktbilder von ihnen ohne ihre Zustimmung aufgenommen oder weitergegeben wurden.

Die Folgen der bildbasierten Gewalt sind enorm. Betroffene, deren Bilder ohne Zustimmung auf Pornoplattformen veröffentlicht wurden, berichten von erschütternden und lebensbedrohlichen Schäden. Untersuchungen zeigen, dass nicht einvernehmlich publizierte Inhalte auf Pornoplattformen leicht zugänglich sind, oft sogar auf den Titelseiten der beliebtesten Pornoplattformen.

„Als die Videos auf PornHub auftauchten, ruinierte das mein Leben. Es hat meine Persönlichkeit zerstört, es hat mir die Freude genommen. Es brachte mir fast zwei Jahre voller Scham, Depressionen, Angst, schreckliche Gedanken, öffentliche Erniedrigung und Narben.“

Quelle: ITV

Regulierungen sind notwendig, um den Betroffenen zu helfen

Pornoplattformen müssen verpflichtet werden, gegen diese weit verbreitete Art des Missbrauchs vorzugehen, so die Forscher. Die fehlende Selbstregulierung der Pornoindustrie lässt die Betroffene im Stich. Außerdem legitimiere und normalisiere die Verfügbarkeit von Bildmaterial von sexueller Gewalt auf Pornoseiten den Missbrauch. Eine Regulierung würde nicht nur den Missbrauch verhindern, sondern auch die Schäden für Tausende von Betroffenen verringern.

Die Forscher*innen bewerten den Änderungsantrag zur Einführung des neuen Artikels 24b DSA (englischer Content), der Teil des IMCO DSA-Berichts ist, als Mindeststandards zum Schutz vor bildbasiertem sexuellen Missbrauch. Sie sind auch der Meinung, dass die vorgeschlagene Regelung wahrscheinlich mit den Menschenrechten vereinbar ist. Die Regelung erkennt die Bedeutung des Rechts der Betroffenen auf Privatsphäre sowie die Verpflichtung des Staates zum Schutz der psychischen Integrität an. Zudem erkennt sie die Tatsache an, dass Online-Missbrauch die Meinungsfreiheit von Frauen einschränkt. Faktoren, die bei einer Entscheidung stark ins Gewicht fallen.

Die vorgeschlagenen Verfahren zur Überprüfung von Nutzer*innen würden die Strafverfolgung unterstützen und wahrscheinlich die Verbreitung von nicht einvernehmlichen Inhalten verringern. Die Bestimmungen für geschulte Content-Moderator*innen helfen bei der Identifizierung von nicht einvernehmlich gepostetem Bildmaterial und könnten die Meldeverfahren und die Entfernung schädlicher Inhalte stärken.