Digital Services Act: Unsere 4 Erfolge in Brüssel

„Ihr seid naiv!” – wurde uns gesagt. Andere meinten, wir wären weltfremd, denn gegen Facebook, Twitter & Co. hätten wir eh keine Chance. So die ersten Reaktionen, als wir erzählten, dass HateAid es in Brüssel mit den großen Tech-Plattformen aufnehmen will. Was stimmt: Lobbyarbeit in der EU war für uns tatsächlich Neuland. Wir hatten keine Erfahrung, keine Kontakte und kaum Geld – im Gegensatz zu den Plattformen, die seit Jahren massiv Lobbyarbeit in Brüssel machen. Dafür waren wir motiviert und hatten ein Ziel: All den Frauen und Mädchen, die täglich auf Social Media angegriffen und erniedrigt werden, in den Verhandlungen zum neuen Internet-Grundgesetz, dem Digital Services Act (DSA) eine Stimme zu geben.

Gespräche über weitreichende Gesetzesänderungen

Und jetzt? Mittlerweile geht in Brüssel kein Weg mehr an uns vorbei! Mit einer über 30.000 Unterschriften umfassenden Petition forden wir die Rechte von zehntausenden Europäer*innen ein. Unser Geschäftsführerin Josephine durfte mehrfach im EU-Parlament die Perspektive von Betroffenen einbringen. EU-Politiker*innen laden uns zu persönlichen Gesprächen ein – und hören uns endlich zu.

Und mittlerweile hat das Europäische Parlament (EP) zu weitreichenden Gesetzesänderungen verhandelt, die das Leben Tausender Betroffener von digitaler Gewalt verändern könnte. Entscheidend ist, dass diese bei den anstehenden Trilog-Verhandlungen auch von anderen EU-Institutionen unterstützt werden.

Wir ziehen zur derzeitigen Position des Europäischen Parlaments eine gemischte Bilanz und erklären euch, welche Erfolge wir feiern und wo in den anstehenden Verhandlungen dringend noch nachgebessert werden muss.

Folgendes haben wir mit eurer Hilfe bisher erreicht

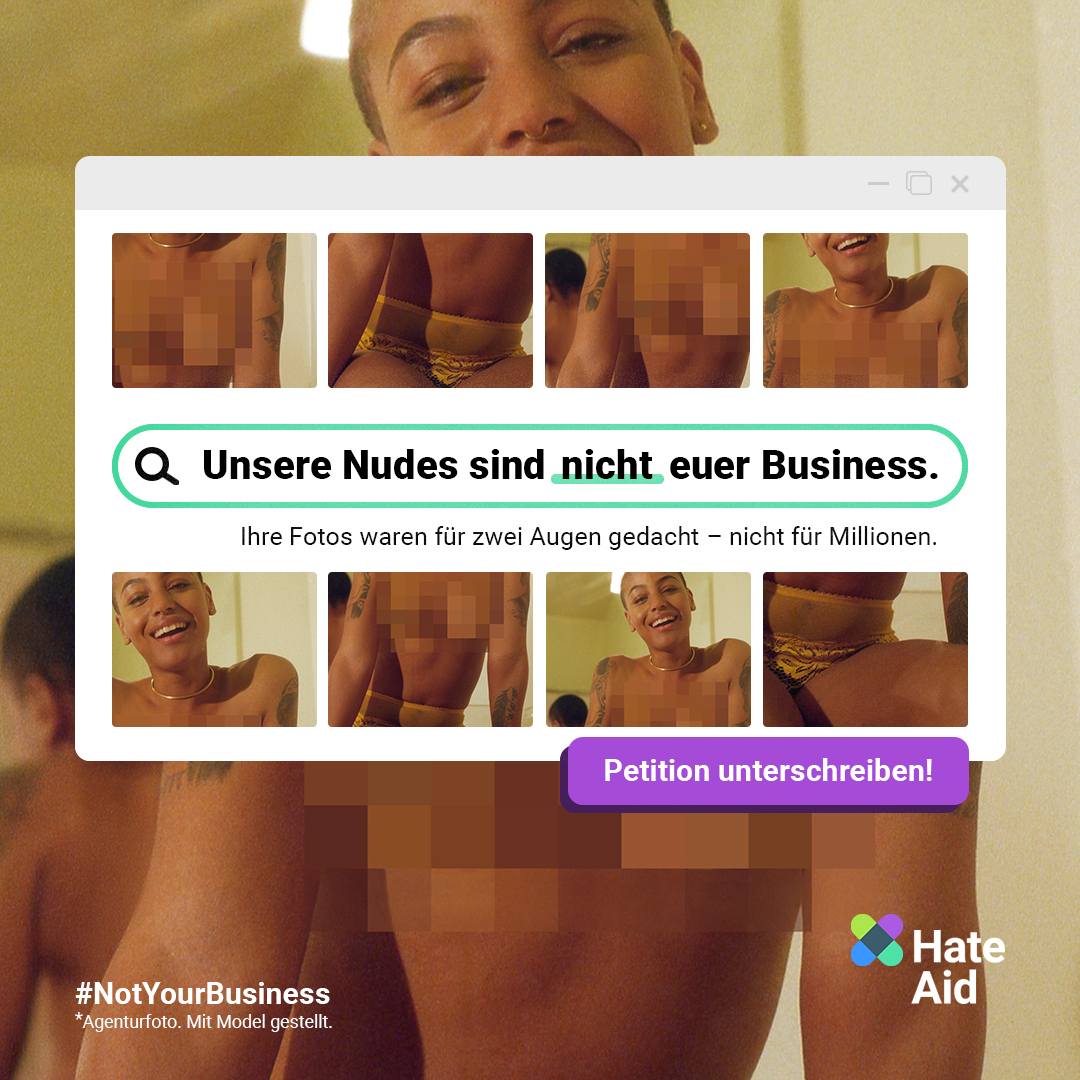

1. Ein Meilenstein für Betroffene: Pornoplattformen regulieren

Endlich könnten Pornoplattformen dazu verpflichtet werden, ernsthaft gegen den Missbrauch von Nacktbildern auf ihren Kanälen vorzugehen. In den Bestimmungen der EU-Politiker*innen sind drei zentrale Punkte vorgesehen:

- jede Person, die Inhalte höchlädt, muss Auskunft über die Identität hinterlegen,

- geschulte Moderator*innen sollen alle Inhalte im Blick behalten und in kritischen Fällen eingreifen,

- separate Meldewege für Missbrauchsmaterial sollen das Melden und Entfernen einfacher machen und beschleunigen.

Gerade Menschen, die von sogenannten Rachepornos, Deepfakes und anderen Formen von bildbasierter Gewalt betroffen sind, könnten nun mehr Möglichkeiten bekommen, um sich dagegen zu wehren. Besonders Frauen sind von dieser Art des bildbasierten sexuellen Missbrauchs betroffen. Gemeinsam mit anderen zivilgesellschaftlichen Organisationen haben wir uns dafür eingesetzt, dass das Problem von den Abgeordneten des Europäischen Parlaments anerkannt und im DSA behandelt werden muss.

„Das Ausmaß und die Folgen des bildbasierten sexuellen Missbrauchs sind verheerend, und ich freue mich, dass das Europäische Parlament sich dieser Sache angenommen hat. Das ist ein Meilenstein, den alle, die sich gemeinsam mit HateAid dafür eingesetzt haben, von Betroffenen über NGOs bis hin zu Wissenschaftler*innen und Abgeordneten des Europäischen Parlaments, feiern sollten.“

Anna-Lena von Hodenberg, Geschäftsführerin von HateAid

2. Power to the Users: Betroffene können sich an Behörden wenden, um Anordnungen zu erwirken

Positiv ist auch, dass das Europäische Parlament unsere Forderung nach mehr Rechten für die Nutzer*innen teilweise in seine Bestimmungen aufgenommen hat. Das betrifft vor allem solche Menschen, die persönlich von illegalen Online-Inhalten betroffen sind. Es soll möglich werden, dass sich Betroffene an Behörden wenden und aktiv Anordnungen gegen Online-Plattformen erwirken, um illegale Inhalte aus der Welt zu schaffen. Ein Beispiel: Wenn eine Nutzerin im Netz mit Morddrohungen oder rassistischer Hetze angegriffen wird und eine Plattform ihre Meldung und Lösch-Aufforderung ignoriert, kann sie sich an Behörden wenden und über diesen Weg das Entfernen beantragen.

3. Öffnet eure Blackbox: Es soll mehr Transparenz über Risiken & Auswirkungen geben

Online-Plattformen schirmen derzeit alle Informationen rund um die Content-Moderation und die Algorithmen ab, auf denen ihre Systeme basieren. Wir haben gemeinsam mit PeopleVsBigTech, einem internationalen Zusammenschluss zivilgesellschaftlicher Organisationen, argumentiert, dass es nicht gerechtfertigt ist, daraus ein Geschäftsgeheimnis zu machen. Denn da der Umgang mit Content aller Art das Wohlergehen von Nutzer*innen weltweit erheblich beeinflussen kann, ist es wichtig, Einblicke in die Mechanismen von Plattformen zu erhalten und diese, wenn nötig, zu regulieren. Das ist umso brisanter mit Blick auf die Enthüllungen von Frances Haugen mit den Facebook-Files. Sie hat als ehemalige Meta-Mitarbeiterin aufgezeigt, dass der Konzern durch bestimmte Algorithmen hasserfüllte Inhalte bevorzugt verbreitet, um Gewinne zu erzielen.

Für das Europäische Parlament ist daher Transparenz das Schlüsselwort. Die Risiken für die öffentliche Sicherheit, Gesundheit, die Grundrechte und eine Reihe anderer Bereiche müssen von sehr großen Online-Plattformen kritisch bewertet werden. Vieles hätte vielleicht verhindert werden können, wenn solche Maßnahmen schon früher eingeführt worden wären. So gäbe es vielleicht unzählige Teenager*innen weniger, die aufgrund der negativen Auswirkungen von Instagram unter psychischen Problemen leiden.

4. Zugang zu Plattformdaten auch für NGOs

Nicht nur AlgorithmWatch, die ihr Instagram-Monitoring-Projekt einstellen mussten, um keine Facebook-Klage zu riskieren, litten in der Vergangenheit unter der Verschlossenheit von Big Tech. Auch andere Organisationen schreckten aus Angst vor möglichen Anzeigen durch große Plattformen zurück, wenn es um den Zugang zu deren Daten ging. Der DSA macht nun Hoffnung darauf, dass sich daran bald etwas ändern könnte. Die Bestimmungen des EP sehen vor, dass nicht nur Forscher*innen, sondern auch bestimmte Organisationen der Zivilgesellschaft Zugang zu Plattformdaten erhalten sollen.

Aber: entscheidende Punkte fehlen

Betroffene haben nach wie vor kein Recht, sich bei der Plattform zu beschweren, wenn hasserfüllte Inhalte gegen sie nicht entfernt wurden. Wenn sich eine Plattform also weigert, Hatespeech, eine Verleumdung oder gar eine Todesdrohung zu löschen, haben Betroffene nicht das Recht, direkt bei der Plattform Beschwerde einzureichen. Ihnen wird auch keine Möglichkeit zur außergerichtlichen Streitbeilegung eingeräumt. Dieses Recht wird nur Nutzer*innen eingeräumt, die sich über Inhalte beschweren wollen, welche von Plattformen möglicherweise zu Unrecht gelöscht wurden.

Das ist nicht nur absolut unverständlich, sondern auch ungerecht! Durch dieses Detail wird ein Zweiklassensystem zwischen Nutzer*innen errichtet. Zudem werden Millionen von Menschen im Stich gelassen, die von Hasskommentaren und Fake News betroffen sind. Daher unser klarer Appell an die Europäische Union:

Betroffene brauchen Schutz und die Möglichkeit, sich zu wehren! Diese Position muss jetzt in den Trilog-Verhandlungen zwischen Kommission, dem Europäischen Parlament und dem Europäischen Rat unbedingt berücksichtigt werden.