Mehr als nur Hate: Wege zu einem positiveren Internet

„Man muss eigentlich immer nur blocken.“ So beschreibt Alex1 seine Erfahrung mit TikTok. Damit ist er nicht allein. Eine neue qualitative Studie der Universität Klagenfurt im Auftrag von HateAid untersucht, wie junge Erwachsene der GenZ (18 – 29 Jahre) Plattformen, Foren und das Internet im Allgemeinen erleben, welche positiven und negativen Erfahrungen sie dort machen und wie sie sich das Netz der Zukunft vorstellen.2

Die Schlagzeilen zu TikTok und Co. sind von Skandalen geprägt: menschenfeindlicher Populismus, islamistische Prediger, Suchtgefahr. Was in der Berichterstattung häufig fehlt, sind die Perspektiven junger User*innen. Die neue Studie möchte das ändern.

Sie ist eine Fortführung der bereits im Juli 2023 stattgefunden quantitativen Studie „In meinem Netz soll es keine Gewalt geben!”. Hier wurden 3.367 Internetnutzende dazu befragt, wie sie digitale Gewalt und Online-Hass wahrnehmen und selbst erfahren.

Daraus ergaben sich ganz neue Fragen: Wo fühlen sich junge Erwachsene im Netz wohl und tauschen sich gerne mit anderen aus? Welche Internetseiten empfinden sie als besonders negativ oder vermeiden sie sogar? Mithilfe der aktuellen Umfrage3 sollen diese offenen Fragen beantwortet und das Erleben junger Erwachsener auf Social Media weiter untersucht werden.

Gute Räume, schlechte Räume

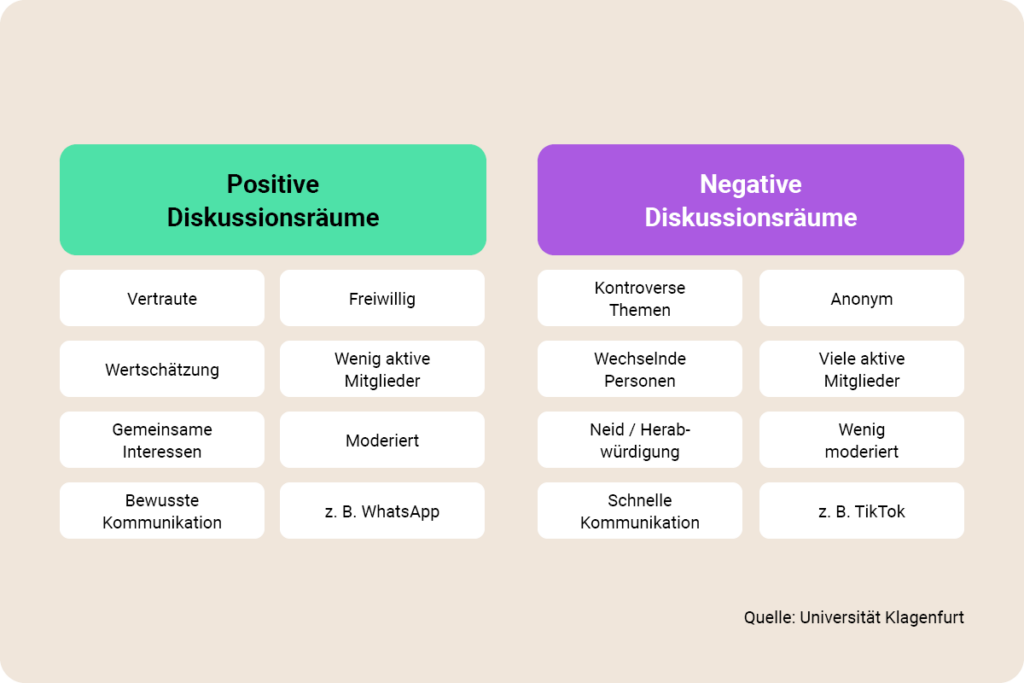

In der Studie wurden die Befragten nach von ihnen als positiv und negativ erlebten Diskussionsräumen befragt und sollten diese charakterisieren. Im Interviewleitfaden wurden positive Räume als bspw. Plattformen beschrieben, wo Austausch und Diskussionen besonders gut laufen, wo sich User*innen besonders wohlfühlen, die sie gerne besuchen und wo sie sich vielleicht sogar mit anderen Personen verbunden fühlen.

Im Vergleich dazu wurden negative Räume als bspw. Gruppen beschrieben, in denen Austausch und Diskussionen nicht funktionieren. Diese Orte erzeugen ein unangenehmes Gefühl oder werden sogar versucht, zu meiden.

Die meisten befragten User*innen halten sich auf Social Media und in Online-Gruppen dort auf, wo sie sich wohlfühlen. Da geht es nicht um das Alter oder das Geschlecht, sondern um gemeinsame Hobbys, Interessen und Erfahrungen. Außerdem unterstützen sich User*innen gegenseitig mit schwierigen Themen wie Trauer oder Krankheit.

Klingt erst einmal nach einer idealen Vorstellung. Schließlich setzt sich auch HateAid für ein positives Netz ein. Nur: Die Geschichte hört leider an diesem Punkt nicht auf. Denn all diese positiven Erfahrungen schützen Menschen nicht vor Hass und Hetze. Auch das belegt die Umfrage. Die meisten Befragten beobachten nämlich auch digitale Gewalt und ein toxisches Klima online.

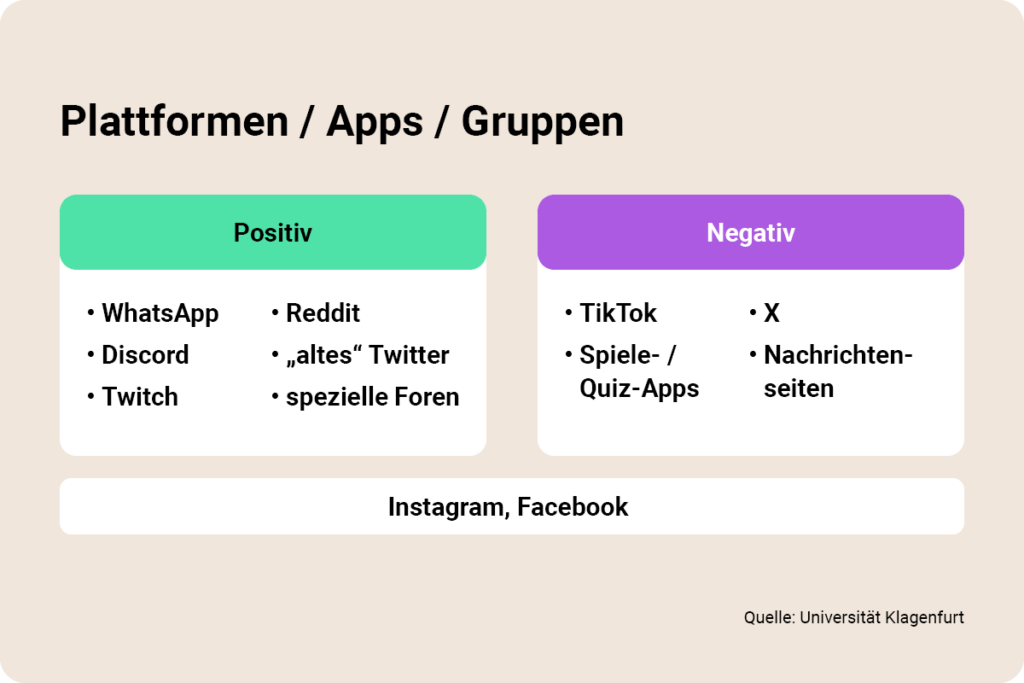

Ein Blick auf die Plattformen. TikTok und X (ehemals Twitter) werden von den Befragten als negativ beschrieben. Facebook und Instagram hingegen zeigen ein gemischteres Bild – je nach Gruppen und Seiten, auf denen sich die User*innen bewegen.

WhatsApp, Twitch und Reddit verbinden die Befragten mit angenehmen Emotionen und Erlebnissen. Kurz: Mit Blick auf die Plattformen fallen die Ergebnisse der qualitativen Interviews sehr gemischt aus.

Interessant ist, dass die Größe der Communitys teilweise als besonders relevanter Faktor für das gute Funktionieren von Online-Räumen genannt wird. Vor allem kleine Gruppen mit häufigem Austausch schätzen die User*innen als positiv und vertrauensvoll ein.

Im Vergleich dazu beschreiben mehrere Befragte die Gruppengröße in negativ erlebten Diskussionsräumen als eher größer. Zudem wechseln die User*innen dort häufiger und es kommen immer wieder neue Personen hinzu, genau die Community-Dynamik von TikTok also. Nur: Es gibt auch ähnliche Plattformen, denen mehrere Befragte positive Eigenschaften zuschreiben, etwa der Gaming-Plattform Discord. Ein Ansatz für vertiefende Forschung in Zukunft.

User*innen, die auf TikTok unterwegs sind, kennen es: Die For You Page wirkt teilweise willkürlich. Die neue Umfrage zeigt: Einigen Befragten ist Selbstbestimmung besonders wichtig. Wenn User*innen auf einer Plattform also selbst entscheiden können, welche Inhalte sie sehen möchten, nehmen sie diese Orte als deutlich positiver wahr.

Plattformen oder Gruppen, die stark algorithmusgesteuert arbeiten, also etwa TikTok, oder über deren Teilnahme nicht freiwillig entschieden werden kann (z. B. Klassen- oder Arbeitschats), werden oft sehr negativ beschrieben.

Emilia (23 Jahre)

Was außerdem klar wird: Selbst überwiegend positiv erlebte Diskussionsräume müssen nicht frei von Negativität sein. Für mehrere Befragte besteht die Negativität darin, dass Diskussionen aus dem Ruder laufen und sich Personen unangemessen, also beispielsweise beleidigend, äußern.

Als großer Unterschied zwischen positiv und negativ erlebten Diskussionsräumen wird angegeben, wie schnell und effektiv mit negativen Inhalten sowohl von Seiten der Plattformen als auch seitens der Community umgegangen wird. Formale Regeln, Netiquetten und Nutzungsbedingungen sind für einen Teil der Befragten kein Garant für eine positive Diskussionskultur – die Durchsetzung spielt eine wichtige Rolle.

Auch HateAid setzt sich dafür ein, dass die Plattformgiganten geltendes Gesetz nicht einfach ignorieren können. Viel zu oft kommen Meta und Co. noch damit durch. Zudem gaben die User*innen an, dass eine gute Moderation entscheidend ist – egal ob diese hauptamtlich, ehrenamtlich oder durch die Community selbst erfolgt.

Ein kurzer Zwischenstand: Die Ergebnisse der Interviews zeigen, dass die Befragten vor allem Diskussionsräume, in denen in kleinen Gruppen gemeinsame Interessen und Erfahrungen geteilt werden, als positiv erleben. Auch der Grad der Selbstbestimmung und eine gute Moderation der Inhalte wirken sich positiv aus.

Vermeiden, aktiv werden, Unterstützung holen

Interessante Frage jetzt: Wie gehen User*innen mit dem mitunter toxischen Klima im Netz um? Die in der Untersuchung befragten Personen berichten, dass sie unterschiedlich auf negative Diskussionsräume reagieren. Dabei handelt es sich um Räume, in denen weder Austausch noch Diskussionen zu funktionieren scheinen. Bei den User*innen führt dies zu unangenehmen Gefühlen bis hin zur Vermeidung dieser Räume.

Die Vermeidung, das belegt die Studie, ist die zentrale Reaktion der User*innen. Sobald Diskussionen als toxisch oder nicht zielführend wahrgenommen werden, vermeiden die User*innen, emotional davon berührt zu werden und ignorieren negative Kommentare und Posts, indem sie weiterscrollen.

In manchen Fällen geben sie an, sogar die Gespräche oder gar die Plattform zu verlassen. Das ist dramatisch, denn: Für ein gerechtes Netz müssen sich alle User*innen wohlfühlen, an Diskussionen teilzunehmen. Ist das nicht der Fall, haben Täter*innen leichtes Spiel und werden noch lauter.

Patrick (29 Jahre)

Die gute Nachricht: Viele zeigen digitale Zivilcourage. Klare Grenzüberschreitungen, wie Rassismus und Beleidigungen motivieren viele der Befragten dazu, aktiv zu werden.

In ein paar Interviews wurde deutlich, dass es Personen gibt, die sich dann konstruktiv in Diskussionen einschalten, um ein Gegengewicht zur Hetze zu bieten. Zudem nutzen die Befragten über alle Altersgruppen hinweg die technischen Funktionen der Social-Media-Plattformen, wie Melden, Blockieren und Löschen.

Hierbei bemängeln einige die teils intransparente oder sehr langsame Bearbeitung durch die Plattformen. Bei Befragten über 30 Jahren stellte sich eine leichte Tendenz heraus: Diese blockieren andere User*innen häufiger und schneller.

Die Hilfe des sozialen Umfelds nahmen hingegen stärker junge Erwachsene in Anspruch. Mehrere der jüngeren Befragten sagen, dass ihnen Freund*innen und die Familie zur Seite stehen, um mit aufwühlenden Emotionen umzugehen und negative Situation zu reflektieren. Wir wissen: Emotionale Selbstfürsorge ist essenziell für User*innen, die mit Hass und Hetze konfrontiert sind.

Die Interviews mit den Befragten verdeutlichen etwas, das HateAid schon lange klarstellt. Nämlich den Bedarf, die technischen Funktionen der Plattformen nachvollziehbarer und transparenter zu gestalten. So, dass User*innen etwa erkennen können, wie schnell und mit welchem Ergebnis Meldungen bearbeitet werden.

Die Umsetzung erfordert nicht viel: Plattformen könnten Informationen benutzerfreundlicher gestalten und leicht zugänglich für alle bereitstellen. Die Reaktionen auf eine Meldung könnten sie den User*innen gegenüber begründen – und schon wäre eine höhere Transparenz hergestellt.

Soziale Medien: Zwischen Inspiration und emotionaler Distanz

Warum Menschen soziale Medien nutzen, ist klar: Unterhaltung, Ablenkung vom Alltag und Zeitvertreib laden zum Surfen und Scrollen ein. Dabei zeigen sich auch keinerlei Unterschiede zwischen verschiedenen Altersgruppen.

Einige der Befragten geben an, dass sie den als positiv empfundenen Diskussionsräumen weitere Wirkungen zuschreiben: etwa gesteigerte Inspiration und Motivation, gegenseitige Unterstützung und Wertschätzung sowie soziale Verbundenheit. Hierbei handelt es sich um wichtige soziale Funktionen, die weit über den reinen Konsum- und Unterhaltungswert hinausgehen.

Genauso haben auch die negativen Diskussionsräume einen Einfluss auf die Stimmung der User*innen. Mehrere Befragte berichten davon, dass Gewaltvorfälle oft Resignation und Fassungslosigkeit erzeugen und User*innen mit schlechter Laune, Ärger oder Scham zurücklassen.

Interessant ist, dass dies nicht zwangsweise zum Abbruch und zum Rückzug aus diesen Räumen führen muss. Für manche Befragte ist es ausreichend, sich von den Inhalten emotional zu distanzieren und zu versuchen, diese nicht mehr auf sich wirken zu lassen.

So kann das Internet der Zukunft aussehen

Die Erfahrungen junger User*innen auf Social Media sind gemischt. Trotzdem sind die genannten Plattformen ein wichtiger Teil ihres Lebens. Ihre Ideen, um das Netz sicherer zu machen, zeigen: Sie wünschen sich ein besseres Internet. Für die konkrete Umsetzung haben sie auch schon ein paar Vorschläge:

Sichere Plattformstrukturen

Über alle Altersgruppen hinweg sind sich User*innen einig: Die Online-Plattformen müssen für ein besseres Internet sorgen und mehr in die Verantwortung genommen werden.

Dies entspricht auch der Forderung von HateAid: Unternehmen sollten direkt bei der Entwicklung einer App oder Plattform den Schutz und die Sicherheit von User*innen im Blick haben. Schon während der Entwicklung der Plattformen sollte Sicherheit ein Teil des Designs werden (“Safety by Design”).

Bessere Moderation und Prüfung

Zudem wünschen sich einige der Befragten, dass die Plattformen problematische Inhalte konsequenter prüfen und transparenter handeln müssen. Viele sehen in Künstlicher Intelligenz (KI) ein nützliches Hilfsmittel.

So könnten Inhalte geprüft und moderiert werden, noch bevor sie öffentlich im Netz sichtbar seien. Andere sind der Meinung, dass KI nur dann helfe, wenn Plattformbetreiber auch klare und transparente Regeln zur Löschung von digitaler Gewalt hätten.

Ein wichtiger Aspekt, den einige Befragte sich wünschen, ist die Moderation durch die User*innen selbst. Die User*innen sollen dann eingreifen können, wenn die Communityregeln verletzt werden. Hieran lässt sich eine wichtige Forderung ableiten: Auf der einen Seite wünschen User*innen mehr Selbstbestimmung durch Moderation.

Auf der anderen Seite wollen sie mehr Möglichkeiten, die Plattformen mitzugestalten. Selbstbestimmung im digitalen Raum kann also bedeuten, Betroffenen die Autonomie und Mittel zu geben, ihre eigenen Bedürfnisse und Grenzen zu definieren und durchzusetzen, anstatt sich ausgeliefert und fremdbestimmt zu fühlen.

Anonymität

In den einzelnen Interviews wurden unterschiedliche Meinungen dazu geäußert, ob es wichtig sei, bei der Nutzung von sozialen Medien anonym bleiben zu können. Dabei ist unter den Befragten unbestritten, dass die Möglichkeit zur anonymen Nutzung von Plattformen Negativität in Diskussionsräumen deutlich verstärkt. Viele Befragte nehmen war, dass User*innen, die nicht identifizierbar sind, sich häufig ungehemmter äußern:

Katja (20 Jahre)

Auf der anderen Seite sehen einige Interviewte auch, dass Anonymität für bestimmte Personengruppen wichtig und unabdingbar sei, damit sie sich überhaupt sicher im Netz bewegen können. Anonymität schaffe hier den nötigen Safer Space5 für sensible Themen.

Verschiedene Lösungen, wie z. B. eine Ausweispflicht gegenüber den Plattformen, wurden von den Befragten angesprochen. Die offenen datenschutzrechtlichen Fragestellungen wurden hierbei jedoch nicht weiter vertieft.

Wichtig erscheint jedoch vielen Befragten, dass es für die Strafverfolgung Möglichkeiten zur Identifizierung von Tatpersonen geben muss, die schnell und unbürokratisch genutzt werden können.

Stärkere Gesetze

In den Interviews wurde deutlich, dass sich die meisten der Befragten stärkere Übernahme von Verantwortung seitens der Plattformen wünschen. Mehrere Befragte sehen die Politik in der Pflicht, durch die Einführung von Gesetzen, Plattformen zu einem aktiveren Umgang mit digitaler Gewalt zu verpflichten. Dadurch würden sicherere Online-Räume geschaffen werden.

Louisa (23 Jahre)

Mehrere Befragte weisen außerdem darauf hin, dass es mehr Handhabe brauche, damit sich Plattformen an die nationalen Gesetze halten. Nationale Regelungen griffen bei multi-nationalen Plattformen teilweise nicht richtig, so dass zu viele Schlupflöcher entstünden.

Strafverfolgungsbehörden schulen

Die Befragten sind sich größtenteils einig, dass die Polizei dort eingreifen muss, wo es strafrechtlich relevant ist. Darüber hinaus empfinden viele die Polizei aber bereits als zu ausgelastet. Die Polizei habe „so viel anderes zu tun“, sei „genügend ausgelastet“, und komme sonst „zu nichts anderem mehr“, stellen Befragte fest.

Drei weibliche Befragte, verteilt über die unterschiedlichen Altersgruppen, zweifeln zudem, ob die Polizei Meldungen von digitaler Gewalt auch ernst nähme.

Hier deckt sich das Ergebnis der Befragung mit Forderungen aus der Zivilgesellschaft, die auch HateAid seit langem erhebt: Strafverfolgungsbehörden müssen im Bereich digitaler Straftaten besser geschult und ausgestattet werden.

Selbst für Veränderung sorgen

Selbstkritisch reflektiert ein Teil der Befragten auch ihre eigene Rolle als User*innen. Letztlich seien sie diejenigen, die in Online-Communitys für eine konstruktive Diskussionskultur sorgen könnten oder nicht.

Die Richtung, in die sich die Diskussionskultur im Internet in den nächsten Jahren verändern wird, sehen manche Befragten eher pessimistisch. Das Netz sei ein Spiegel der Gesellschaft, sagen einige Personen – hier müsse ein Wandel geschehen.

Wie kann diese Forderung, dass junge Menschen dazu befähigt werden sollen, selbst für die Veränderungen zu sorgen, konkret umgesetzt werden? Ein gesellschaftlicher Wandel hin zu mehr Reflexion und Verantwortungsbewusstsein im Miteinander wird als essenziell angesehen, um etwas gegen die negative Entwicklung der Online-Diskussionskultur zu tun. Hierbei können außerdem mehr Vernetzung und Austausch untereinander sowie bessere Aufklärung zu dem Thema hilfreich sein.

Meinungsvielfalt, aber ohne Hass

Die vorliegenden qualitativen Interviews sind nur ein Schlaglicht auf die Erfahrungen der GenZ auf Social Media. Trotzdem können sie einige wichtige Erkenntnisse liefern: Wenig überraschend ist, dass junge User*innen versuchen, sich überwiegend an den von ihnen als sicher wahrgenommenen Orten im Netz aufzuhalten.

Wenn das gelingt, haben diese eine wichtige soziale Funktion. Sie geben Inspiration und Motivation, so, wie es in einem besseren Internet eben sein sollte. Gleichzeitig sind negative Räume manchmal alternativlos für sie, weil sie nur dort bestimmte Informationen bekommen oder bestimmten Aktivitäten nachgehen können.

Wichtig außerdem: Auch in positiven Räumen kann es mitunter zu gewaltvollen Situationen kommen. Viele Befragte sind daher auch erschöpft von der digitalen Gewalt und dem damit verbundenen psychischen Stress, dem sie langfristig ausgesetzt sind. Sie reagieren mit Vermeidung und emotionalem Rückzug.

Langfristige Forschung ist wichtig. Nur so können wir erfahren, wie wir soziale Medien sicherer machen können. Ansetzen sollte man also an den Plattformen und Online-Räumen, die von User*innen schon als sicher wahrgenommen werden. Von ihnen lässt sich lernen.

Aus den Befragungen wird klar, dass es bereits Communitys und Orte gibt, die als ein „Safer Space“ empfunden werden. Diese sind Orte offener und wertschätzender Diskussionen. Hass und digitale Gewalt werden dort mittels Moderation und dem Einschreiten der Community erfolgreich geregelt.

Diese Communitys sind oft klein und stabiler, wodurch sich gemeinsamer Zusammenhalt bildet. Hier sind ähnliche Dynamiken zu beobachten, die auch in kleineren Gruppen im analogen Leben ähnliche Wirkungen haben: die Gruppe sanktioniert unerwünschtes Verhalten und selektiert, welche User*innen teilhaben können, um sich vor Gewalt zu schützen.

Nun stellt sich die Frage: Wie können auch auf den sozialen Medien in Zukunft mehr solcher positiver Räume geschaffen werden, so dass sich verschiedenste Personen online wohlfühlen?

Dazu sehen die Befragten der hier vorliegenden qualitativen Untersuchung sich als User*innen selbst, aber auch die Plattformen und vor allem auch die Politik in der Verantwortung. Sie fordern klare und wirkungsvolle Maßnahmen und verpflichtende Regelungen.

Durch die Interviews wird deutlich, dass es den Befragten nicht darum geht, Streit zu vermeiden oder Meinungsunterschiede zu ignorieren. Sie wünschen sich eine sichere Teilnahme an einem Diskurs und Austausch im Sinne der Meinungsvielfalt. Im Internet der Zukunft darf, muss und soll diskutiert werden – aber der Umgangston muss dabei konstruktiv bleiben.

Zukünftige Forschung sollte sich den Fragen widmen, was jungen Menschen fehlt, um mehr Selbstbestimmung zu ermöglichen. Die Ergebnisse zeigen, dass der Wunsch und die Idee bereits vorhanden sind.

An der konkreten Umsetzung mangelt es. Mit Fokus auf die Plattformen kann die Forschung die Eigenschaften der positiven Räume, z. B. gemeinsame Interessen und kleine Gruppen noch mehr untersuchen und beleuchten, inwieweit auch große Plattformen diesbezüglich zu sicheren Orten werden können.

Weitere Analysen und Zahlen zu digitaler Gewalt und dem Umgang mit ihr, findest du hier.

- Alle Interviews wurden pseudonymisiert, sodass die genannten Namen nicht den Klarnamen der Interviewpartner*innen entsprechen. ↩︎

- Zwischen Sommer und Herbst 2024 wurden 14 Personen der erwachsenen GenZ (18 bis 29 Jahre) sowie 15 Personen älterer Generationen (über 30 Jahre; als Vergleichsgruppe) befragt. ↩︎

- Leitfadengestützte qualitative Interviews werden eingesetzt, um Haltungen, Vermutungen und Erklärungsansätze von Individuen zu einem bestimmten Thema zu sammeln. Sie erheben keinen Anspruch auf Repräsentativität und dienen vor allem dazu, mehr über bisher nicht beachtete Denkansätze zu erfahren. Die Häufigkeit der Nennungen zu einzelnen Themen ist hierbei unerheblich. ↩︎

- Das Wort “quitten” bezieht sich in diesem Zusammenhang auf das englische Wort “to quit” (deutsch beenden, aussteigen). ↩︎

- Räume (digital oder analog), in denen sich Menschen sicher fühlen sollen, sich bestärken und gegenseitig unterstützen. ↩︎

Titelbild: Shutterstock / Davide Angilini