Kleine Veränderungen – großer Effekt: Wie Hass im Netz reduziert werden kann

Zwischen Katzenvideos und Nachrichten der besten Freundin ploppen sie wie selbstverständlich auf: Beleidigungen, Drohungen und Falschzitate. Doch das sollte es nicht sein. Ein Mindestmaß an Produktsicherheit können und sollten Verbraucher*innen auch im digitalen Raum verlangen dürfen. Denn in der analogen Welt ist das Standard: Bei Autos, Medikamenten oder Lebensmitteln wird genau getestet, ob sie für die Nutzer*innen auch gefährlich sein könnten.

Doch wenn es um soziale Netzwerke, Apps oder KI geht, werden oft Produkte auf den Markt gebracht, ohne zuvor mögliche Schäden für Einzelpersonen aber auch unsere Gesellschaft zu untersuchen. Einige Plattformen wie etwa Mastodon wollen neue Wege gehen. Nach der Übernahme von Twitter durch Elon Musk zog es zahlreiche Nutzer*innen in das dezentral organisierte Netzwerk. Wir haben uns das im Rahmen einer Datenanalyse näher angesehen und gefragt: Geht ein anderes Produktdesign tatsächlich mit weniger Hass einher? Und falls ja, was können wir daraus lernen?

Schutz der Nutzenden durch Plattformen ist möglich

Die gute Nachricht vorweg: Ein sichereres Internet ist möglich. Unsere Analyse zeigt, dass sich auf Mastodon deutlich weniger potenziell beleidigende und verletzende Kommentare finden als auf Twitter. Es ist für soziale Netzwerke also machbar, Nutzende effektiv vor Hass zu schützen. Das können sie zum Beispiel, indem sie ihre Plattformen in ihrer Struktur sicher gestalten. Dies wird dann Safety by Design, Security by Design oder Prevention by Design genannt.

Dieser Schutz ist notwendig, denn weltweit tragen digitale Gewalt und Desinformation zur Spaltung von Gesellschaften bei: Etwa dann, wenn Rechtsextreme sich online zu koordinierten Angriffen auf politische Gegner*innen verabreden, um diese mundtot zu machen. Oder dann, wenn Verschwörungsideologien verbreitet werden, um das Vertrauen in den Staat und die Politik zu untergraben. Wie alltäglich Hass und Hetze im Netz sind, zeigen Umfragen: Allein innerhalb der Europäischen Union sind mehr als 50 Prozent der jungen Erwachsenen von digitaler Gewalt betroffen. Und die Plattformen? Weisen die Verantwortung für diese Entwicklung von sich.

Gefahr als Geschäftsmodell

Dabei ist die Art, wie soziale Netzwerke funktionieren, kein Naturgesetz. Im Gegenteil: Es ist eine bewusste Entscheidung der Plattformen, sie auf eine bestimmte Art und Weise zu designen. Und damit auch die Folgen in Kauf zu nehmen: Mit ihren Algorithmen tragen Plattformen wesentlich zur massenhaften Verbreitung von Gewalt und Desinformation bei – und sie wissen darum: Vor rund zwei Jahren veröffentlichte das Wall Street Journal die sogenannten Facebook Files. Die Journalist*innen werteten in mehreren Artikeln interne Dokumente, Chatprotokolle und Präsentationen von Meta aus.

Die Unterlagen sowie Aussagen der Whistleblowerin Frances Haugen zeigen: Dem Unternehmen, zu dem unter anderem Facebook und Instagram gehören, war die schädliche Wirkung seiner Angebote bewusst. Hass und polarisierende Inhalte würden verstärkt, um eine höhere Aktivität von Nutzer*innen und Werbeeinnahmen zu erzielen, so Haugen. Hingegen würden kaum Maßnahmen ergriffen, um den Schaden einzudämmen.

Willkürliches Vorgehen der Plattformen gegen digitale Gewalt

Auch wir beobachten: Plattformen gehen oftmals nur willkürlich gegen digitale Gewalt vor. Anpassungen von Produktdesign und Algorithmen sind in der Regel nicht transparent, einmal eingeführte Maßnahmen sind kaum verlässlich. So machte beispielsweise Twitter nach der Übernahme durch Elon Musk immer wieder mit Entscheidungen zur Wiederherstellung vormals gesperrter Accounts und Personalkürzungen bei Moderationsteams Schlagzeilen.

Zuletzt sorgten unter anderem die Einführung des neuen Bezahlmodells „Twitter Blue“ und Lesebeschränkungen bei Nutzer*innen für Unmut. Studien legen darüber hinaus eine deutliche Zunahme etwa von antisemitischen und rassistischen Posts auf der Plattform nahe. In der Folge wechselten viele Nutzer*innen zu anderen Netzwerken. Eines davon ist das als Alternative zu Twitter gehandelte Mastodon. Aber geht es dort wirklich anders zu?

#UnserInternet, aber sicher!

Das Internet sollte ein Ort sein, an dem alle Menschen sicher sind. Leider ist das noch nicht der Fall: Beleidigungen, Drohungen oder Phishing-Attacken stehen für viele Menschen an der Tagesordnung.

Doch die Plattformen könnten einiges dagegen tun. Zum Beispiel sichere Strukturen und Funktionen einbauen und safe by Design werden.

Dafür kannst du dich einsetzen. Denn auch online gelten Menschenrechte, die dich vor Gewalt schützen. Wir zeigen dir, welche Rechte du hast und wie wir uns gemeinsam #UnserInternet zurückholen.

Dezentrale Organisation im Fediverse

Bei Mastodon handelt es sich um ein dezentral organisiertes soziales Netzwerk. Das bedeutet: Im Gegensatz zu den meisten anderen Plattformen steht dahinter nicht ein einziges großes Unternehmen. Stattdessen gehört Mastodon zum sogenannten „Fediverse“. Das besteht aus einer Vielzahl verschiedener Server – auf Mastodon „Instanzen“ genannt – die auf Basis des offenen Protokolls „Activity Pub“ miteinander kommunizieren können. Ähnlich wie bei E-Mails sind also nicht alle Nutzer*innen bei einem einzelnen Anbieter, können aber dennoch Nachrichten untereinander austauschen.

Neben Mastodon gibt es im Fediverse noch weitere Dienste wie etwa die Fotoplattform „Pixelfed“ oder „PeerTube“, eine Software für Videoplattformen. Auch „Threads“, das neue Netzwerk von Facebooks Mutterkonzern Meta soll laut Ankündigung künftig mit dem Activity-Pub-Protokoll kompatibel sein. Derzeit ist die nicht kommerzielle Twitter-Alternative Mastodon jedoch die bekannteste Anwendung. Eine Untersuchung der Süddeutschen Zeitung von 2022 zeigt: Nach der Übernahme von Twitter durch Elon Musk kam es beispielsweise auf der größten Instanz mastodon.social zu einem enormen Zuwachs an Accounts.

Geringerer Anteil potenziell beleidigender Kommentare auf Mastodon

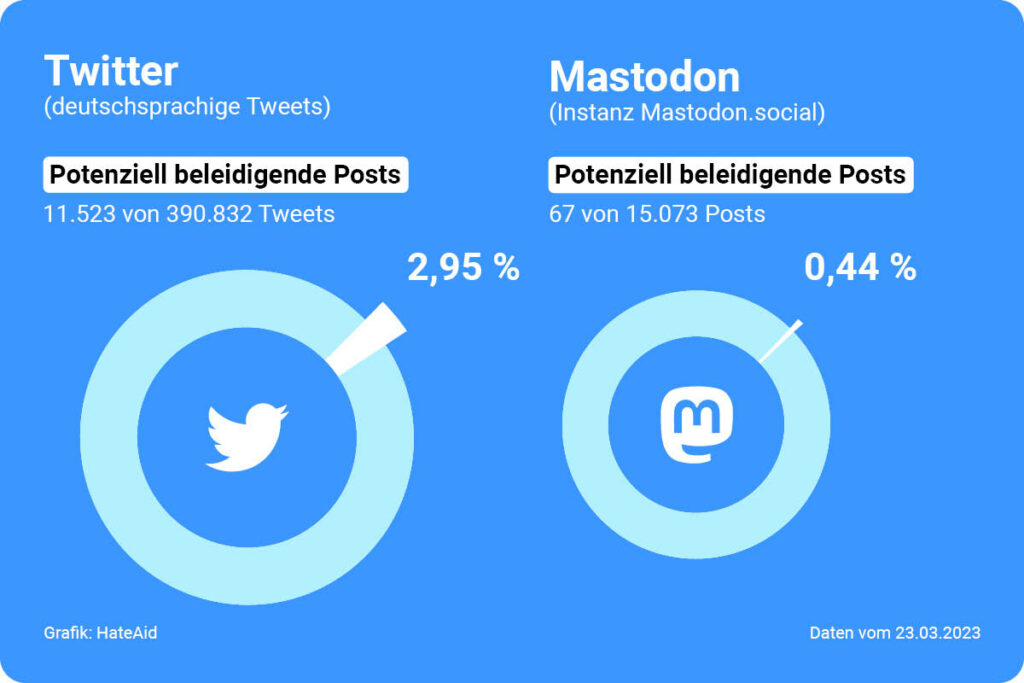

Im Rahmen einer Datenanalyse haben wir uns genauer angesehen, ob sich das Ausmaß potenziell beleidigender und hasserfüllter Inhalte auf Mastodon von dem auf Twitter unterscheidet. Hierfür wurden mittels künstlicher Intelligenz² alle innerhalb eines zufällig ausgewählten Tages³ geposteten deutschsprachigen Kommentare des sogenannten „Federated Feed“ auf mastodon.social ausgewertet. Dieser beinhaltet nicht nur alle Kommentare dieser Instanz, sondern auch die Inhalte von Personen auf anderen Servern, denen Nutzer*innen von mastodon.social folgen.

Hierzu haben wir uns alle an diesem Tag erstellten deutschsprachigen Posts angesehen, das waren 15.073. Für denselben Zeitraum wurden alle anhand von Wörterlisten erkennbar deutschsprachigen Tweets auf Twitter ausgewertet, das waren 390.832 Tweets⁴. Die Ergebnisse zeigen: Der Anteil potenziell beleidigender Kommentare fällt auf Mastodon deutlich geringer aus als auf Twitter. Laut KI weisen 2,95 % der untersuchten Tweets mit einer Wahrscheinlichkeit von mehr als 85 % beleidigende und verletzende Sprache auf. Bei den Kommentaren auf Mastodon sind das lediglich 0,44 %. Eine zweite verwendete KI⁵ kommt zu ähnlichen Ergebnissen.

Eigene Regeln dank föderaler Struktur

Dabei handelt es sich selbstverständlich nur um einen Bildausschnitt. Zum jetzigen Zeitpunkt weist Mastodon mit etwa 1,3 Millionen monatlich aktiven Nutzer*innen deutlich geringere Zahlen auf als Twitter. Doch dass das Netzwerk einiges anders macht als große Plattformen, ist einen genaueren Blick wert: So ermöglicht die föderale Struktur es Nutzer*innen, mit ihrem Account auf eine andere Instanz umzuziehen. Das ist vor allem deshalb interessant, weil jede Instanz eigene Regeln aufstellen kann – etwa darüber, welche Inhalte geduldet werden und welche nicht. Wer also mit der Moderation des bisher genutzten Servers nicht einverstanden ist – etwa, weil zu viele Hasskommentare online stehen bleiben – kann hieraus Konsequenzen ziehen, ohne bestehende Kontakte zu verlieren.

Teilautomatisierte Blockierfunktion

Und es gibt noch weitere Schutzfunktionen: Die meisten sozialen Netzwerke bieten die Möglichkeit, manuell einzelne Nutzer*innen zu blockieren. Das wird bei mehrere zehntausend Accounts umfassenden rechten bis rechtsextremen Ökosystemen auf Plattformen wie Twitter jedoch schnell zum aufwendigen Zeitvertreib. Zwar ist es auch bei Mastodon möglich, andere zu blockieren, stummzuschalten und zu melden. Doch darüber hinaus können ganze Instanzen, und so mit wenigen Klicks Tausende Nutzer*innen, auf einmal geblockt werden. Auch Instanzen untereinander können das tun („deföderieren“ genannt).

Einige haben etwa alle bekannten rechtsradikalen Server im Fediverse blockiert, um ihre Nutzer*innen vor Attacken aus diesem Spektrum zu schützen. Mit Projekten wie „FediBlockHole“ – einem Tool, mit dem die eigene Blockliste mit anderen Listen aus vertrauenswürdigen Quellen synchronisiert wird – kann dieser Prozess sogar teilautomatisiert werden.

Umfangreiches Safety-by-Design-Konzept

All das sind interessante und vor allem neue Ansätze. Darüber hinaus gibt es weitere Funktionen, die teils bisher schon auf unterschiedlichen sozialen Netzwerken angewendet werden und von denen auch Mastodon noch profitieren könnte. Hierzu gehören, dass

- Antworten verborgen werden können, um „Hijacking“ von Kommentarspalten für radikale Inhalte zu vermeiden. Denn durch Kommentare unter Beiträgen von Accounts mit hoher Reichweite versuchen Trittbrettfahrer*innen immer wieder, Hass und Desinformation zu verbreiten,

- der Kreis der Personen, die auf einen Beitrag antworten können, eingeschränkt werden kann. So erhalten Nutzer*innen mehr Kontrolle darüber, mit wem sie interagieren,

- Meldewege für Nutzer*innen transparent und Kriterien für Moderationsentscheidungen ersichtlich sind,

- Moderator*innen automatisierte Tools zur Verfügung gestellt werden, die sie in ihrer Arbeit unterstützen. So sollten insbesondere Darstellungen des sexuellen Missbrauchs von Kindern (sog. “CSAM”) umgehend und proaktiv entfernt werden – nicht erst dann, wenn sie gemeldet werden. Dabei geht es nicht um eine Filterung von Inhalten, sondern um eine Unterstützung der Moderationsarbeit, die in solchen Fällen sehr traumatisierend sein kann,

- Privatnachrichten Ende-zu-Ende verschlüsselt übermittelt werden können. Derzeit sind Direktnachrichten in der Nutzungsoberfläche von Mastodon nicht klar von öffentlichen Beiträgen getrennt. Stattdessen erscheinen sie als Post, der lediglich für die Person sichtbar ist, die adressiert wird. Dies sollte auch in der Programmierschnittstelle entsprechend getrennt werden,

- auf divers zusammengesetzte Moderationsteams gesetzt wird, um Diskriminierung frühzeitig zu erkennen und von Beginn an verschiedene Perspektiven einzubinden.

Bisher setzt keine Social-Media-Plattform diese Maßnahmen in ihrer Gesamtheit um – auch Mastodon nicht. Vielmehr werden einzelne Sicherheitsmaßnahmen für Nutzer*innen auf den Plattformen zwar eingeführt, können aber auch jederzeit wieder willkürlich abgeschafft oder verändert werden. Wie schnell das gehen konnte, zeigte die Übernahme von Twitter durch Elon Musk, der Twitters bisherige Sicherheitsmaßnahmen radikal in Frage stellte und zum Teil sogar abschaffte oder zweckentfremdete. Würden die schon existierenden Maßnahmen auf allen Plattformen gebündelt und in ihrer Gesamtheit konsequent angewendet, könnten sie einen ersten Entwurf für ein umfassendes „Safety-by-Design“-Konzept (Produktsicherheit) ergeben.

Safety by Design für ein friedvolleres Netz

Die Analyse und der genauere Blick auf das dezentral organisierte Fediverse zeigen: Soziale Netzwerke machen es sich zu einfach, wenn sie sagen, dass sich die bisherige Situation im Netz leider nicht oder kaum ändern ließe. Wir fordern: Plattformen müssen so gestaltet werden, dass die davon ausgehenden Schäden für einzelne Personen und unsere Demokratie minimiert werden. Hier sind auch die Social-Media-Konzerne gefragt, selbst wenn das bedeutet, dafür gegebenenfalls auf Profite zu verzichten. Safety by Design ist möglich – und es ist notwendig.

Diese Analyse wird gefördert durch die Teilnehmenden der Deutschen Postcode Lotterie.

______________

¹ Angaben für den „Federated Feed“ auf Mastodon.social.

² Die Auswertung der Daten erfolgte mittels der Programmiersprache Python. Die Grundlage für die Bewertung potenziell beleidigender und hasserfüllter Kommentare bildeten die Perspective API (Score „Insult“) von Google sowie das Tool Moderations (Kategorie „hate“) von OpenAI. Erhebungen wie diese sind nach Änderungen des Datenzugriffs seitens Twitter für uns derzeit so nicht mehr durchführbar.

³ 23.03.2023

⁴ Die Datenrecherche erhebt daher keinen Anspruch auf Vollständigkeit. Die von uns untersuchte Anzahl deutschsprachiger Tweets wurde zunächst mithilfe von Wörterlisten, die häufige deutsche Begriffe wie Artikel und Präpositionen umfassen identifiziert. Die sprachliche Zuordnung wurde anschließend überprüft. Es ist möglich, dass die Gesamtzahl aller deutschsprachigen Tweets am fraglichen Tag insgesamt noch höher ausfällt.

⁵ Angaben im Text für die Perspective API von Google. Die zweite verwendete KI von OpenAI (Moderations „hate“) kommt zu folgenden Ergebnissen: 3,45 % potenziell hasserfüllte Tweets auf Twitter, 0,6 % potenziell hasserfüllte Kommentare auf Mastodon.